|

|

|||||||

|

|

|

Опции темы |

Рейтинг:

|

Опции просмотра |

|

|

#81 |

|

Пользователь

Регистрация: 01.12.2016

Сообщений: 242

Вы сказали Спасибо: 0

Поблагодарили 1 раз в 1 сообщении

Репутация: 10

|

Сборник статей #8: ссылки с GET параметрами, скачивание Google документов, очистка очереди через API(https://a-parser.com/threads/5483/)

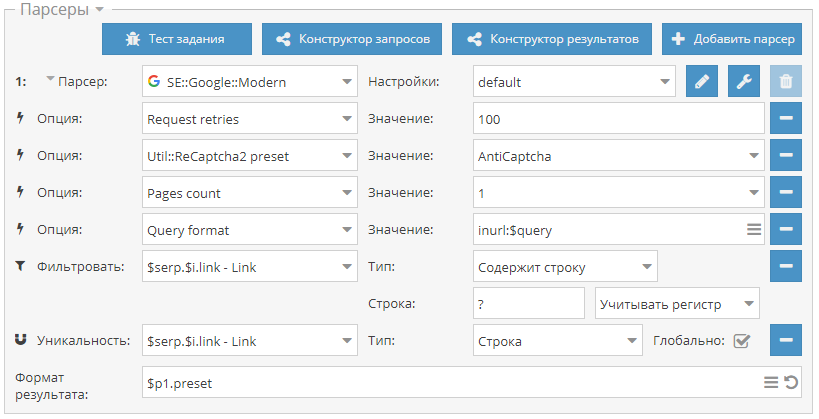

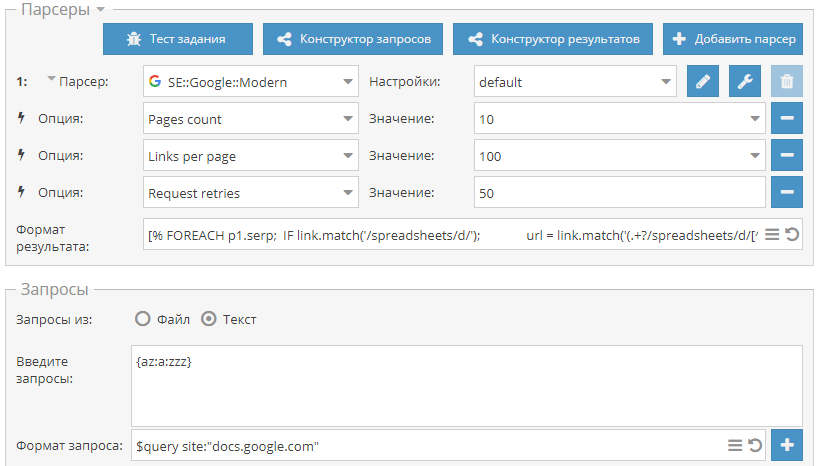

8-й сборник статей. В нем мы научимся парсить ссылки с GET параметрами, искать в поиске Google и скачивать документы, а также узнаем как очищать очередь заданий через API. Поехали! Сбор ссылок с GET параметрами В техническую поддержку часто задают вопрос, как собирать ссылки с GET параметрами для поиска SQL уязвимостей. Поэтому, по ссылке выше мы расскажем как это сделать, используя стандартный парсер Google.  Поиск и скачивание Google документов За последнее время уже несколько раз появлялись новости о том, что Google индексирует пользовательские документы, размещенные в их одноименном сервисе и открытые для доступа по ссылке. Соответственно все эти файлы становятся доступны в поиске. И пока Google разбирается с этим, по ссылке выше мы рассказываем как можно искать и скачивать такие документы.  Работаем с API, часть 3 Третья и заключительная часть из цикла статей по работе с A-Parser через API. В ней на примере очистки очереди задач будет рассмотрена работа со вспомогательными запросами, которые позволяют работать с очередью заданий. Все детали - по ссылке выше.  https://telegram.me/joinchat/B52bKz_xVDH2GDiEU1MPsQ |

|

|

|

|

|

#82 |

|

Пользователь

Регистрация: 01.12.2016

Сообщений: 242

Вы сказали Спасибо: 0

Поблагодарили 1 раз в 1 сообщении

Репутация: 10

|

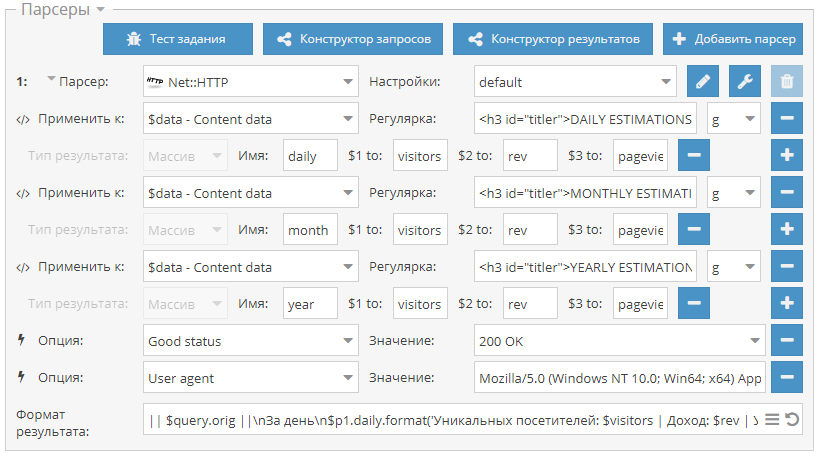

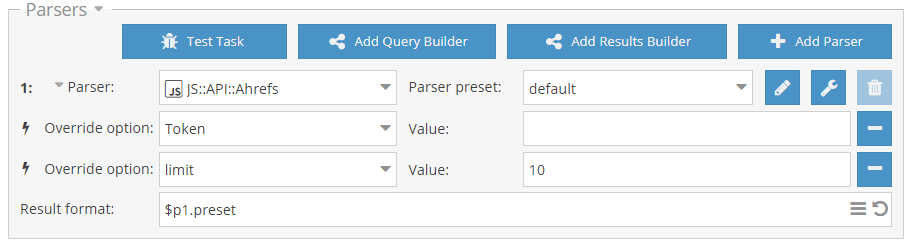

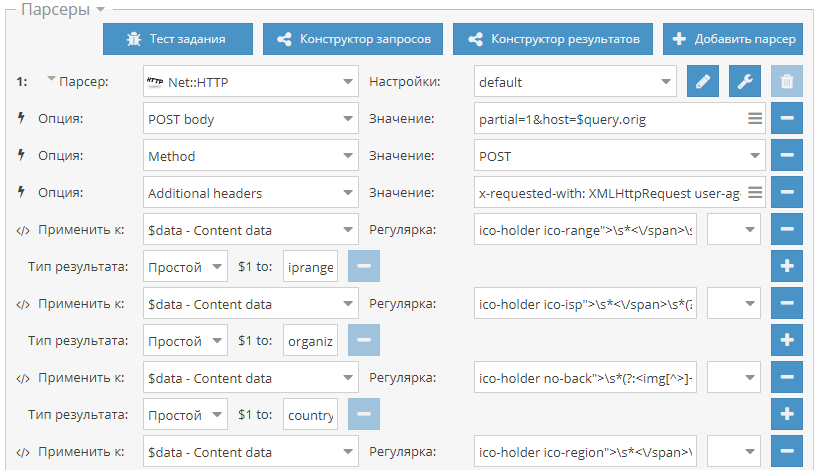

34-й сборник рецептов, в котором опубликован пресет для оценки количества трафика на сайтах, парсер Ahrefs через API и пресет для парсинга информации об IP адресах. Поехали!

Чек трафика сайта Пресет для проверка трафика сайта через сервис siteworthtraffic.com. Собираются данные о количестве уникальных постетителей и просмотров, а также о доходе с рекламы. Оценка трафика на сайтах может быть полезна для фильтрации списка сайтов по критерию прибыльности и популярности. Пресет доступен по ссылке выше.  Парсер Ahrefs на основе Ahrefs API Парсер для сбора данных из популярного сервиса Ahrefs через их официальное API. Собирается множество данных, которые позволяют оценивать домены по различным характеристикам. Для использования нужен API ключ, который приобретается отдельно.  Парсинг подсети и организации по IP Небольшой пресет для сбора информации об IP адресе, а именно: подсеть, организация, страна и город. Данные собираются из сервиса whoer.net.  Еще больше различных рецептов в нашем Каталоге (https://a-parser.com/resources/)! Предлагайте ваши идеи для новых парсеров здесь (https://a-parser.com/threads/3464/), лучшие будут реализованы и опубликованы. Подписывайтесь на наш канал на Youtube (https://www.youtube.com/channel/UCvypGICrfCky8tPtebmIvQw) - там регулярно выкладываются видео с примерами использования A-Parser, а также следите за новостями в Twitter (https://twitter.com/a_parser).  https://telegram.me/joinchat/B52bKz_xVDH2GDiEU1MPsQ |

|

|

|

|

|

#83 |

|

Пользователь

Регистрация: 01.12.2016

Сообщений: 242

Вы сказали Спасибо: 0

Поблагодарили 1 раз в 1 сообщении

Репутация: 10

|

1.2.570 - новые парсеры API::Server::Redis и SE::Startpage, улучшения в существующих парсерах(https://a-parser.com/threads/5523/)

Улучшения

https://telegram.me/joinchat/B52bKz_xVDH2GDiEU1MPsQ https://telegram.me/joinchat/B52bKz_xVDH2GDiEU1MPsQ |

|

|

|

|

|

#84 |

|

Пользователь

Регистрация: 01.12.2016

Сообщений: 242

Вы сказали Спасибо: 0

Поблагодарили 1 раз в 1 сообщении

Репутация: 10

|

[URL=https://a-parser.com/threads/5553/]Видео урок: Поиск страниц контактов[/URL]

В этом видео уроке рассмотрен пример решения задачи по поиску страниц контактов у заданного списка сайтов. Также парсится тайтл и все это сохраняется в CSV файл. В уроке рассмотрено:

[URL=https://telegram.me/joinchat/B52bKz_xVDH2GDiEU1MPsQ]  [/URL] [/URL] |

|

|

|

|

|

#85 |

|

Пользователь

Регистрация: 01.12.2016

Сообщений: 242

Вы сказали Спасибо: 0

Поблагодарили 1 раз в 1 сообщении

Репутация: 10

|

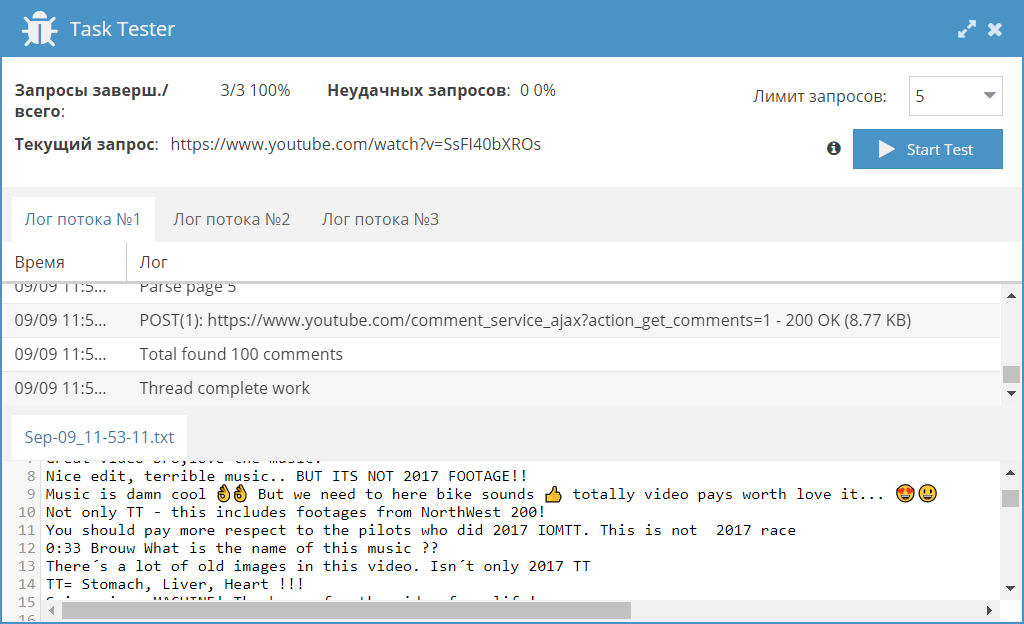

Сборник рецептов #35: комментарии на Youtube, контакты на сайтах и японский Yahoo(https://a-parser.com/threads/5572/])

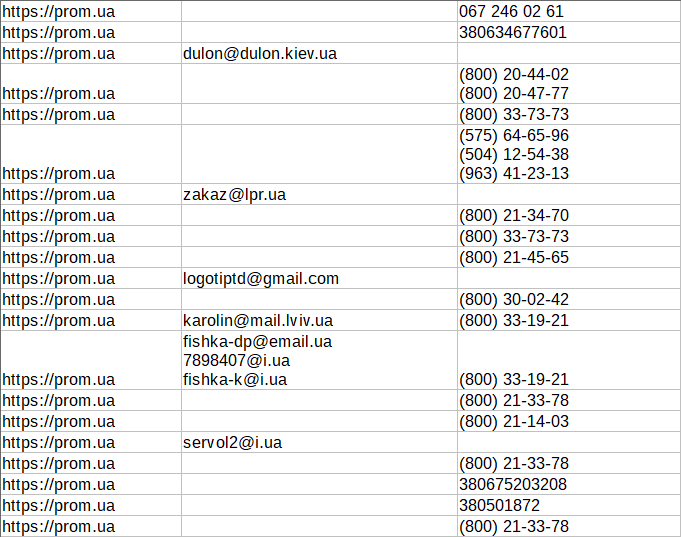

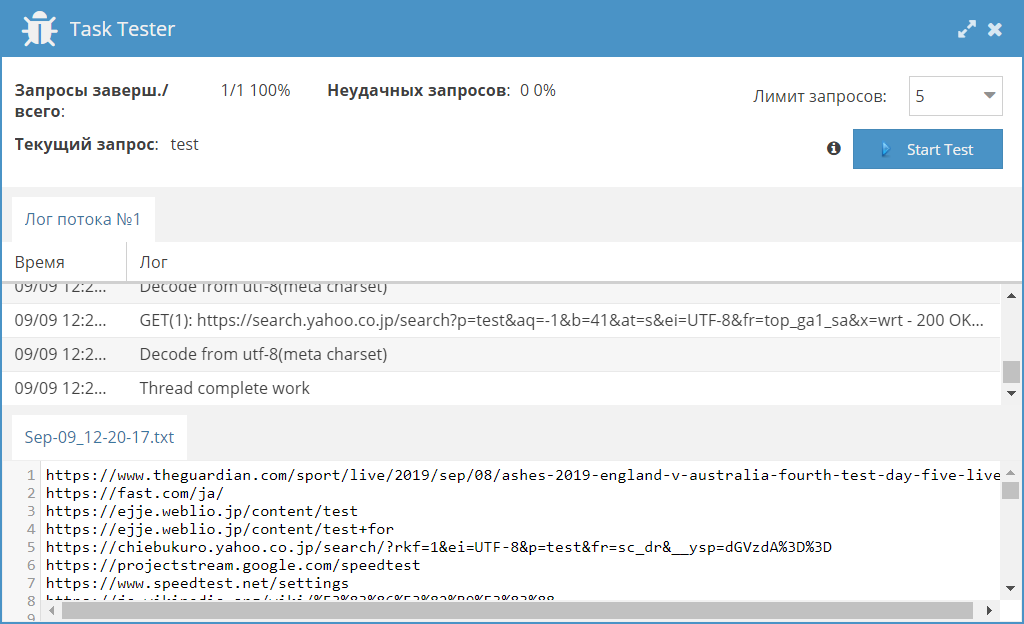

35-й сборник результатов, где мы будем собирать комментарии из Youtube, искать контакты (телефоны и почты) на сайтах, а также парсить японскую выдачу Yahoo. Поехали! [BПарсинг комментариев из Youtube[/B] Представляем вашему вниманию JS парсер комментариев для видео на Youtube. С его помощью можно собирать тексты комментариев, а также информацию об авторах комментариев индивидуально для каждого видео. Также реализована возможность указывать количество страниц с комментарими, что позволяет при необходимости ограничить их сбор и тем самым увеличить скорость работы.  Извлекаем телефоны, начинающиеся на 3 с помощью HTML::EmailExtractor Пресет, в котором показано, как с помощью HTML::EmailExtractor HTML::EmailExtractor собирать контакты со страниц сайтов. Данный пресет предназначен для сбора e-mail и телефонов, начинающихся с 3 (Украина), но при необходимости можно немного изменить регулярные выражения и собирать телефоны других стран.  SE::Yahoo::JP JS парсер для парсинга японской выдачи Yahoo. Используется домен search.yahoo.co.jp. Собираются ссылки, анкоры и сниппеты, а также есть возможность задать количество страниц для парсинга.  https://telegram.me/joinchat/B52bKz_xVDH2GDiEU1MPsQ |

|

|

|

|

|

#86 |

|

Пользователь

Регистрация: 12.09.2019

Сообщений: 11

Вы сказали Спасибо: 0

Поблагодарили 0 раз(а) в 0 сообщениях

Репутация: 10

|

На сегодняшний день парсеры, это огромные SEO- комбайны, способные помочь SEO специалистам и вебмастерам любого уровня подготовки.

Можно также обратится к специалисту и вам напишут парсер под ваши запросы. Здорово то, что не нужно искать фрилансеров на просторах интернета. Алгоритм работы у таких программ практически одинаков. В интернете часто встречаются выражения, из которых следует, будто парсер (поисковый робот, бот) путешествует по интернету. Но в принципе эта программа никогда не покидает компьютера, на котором она инсталлирована. То есть парсер в корне отличается от вируса, хотя в чем то, он напоминает троянскую программу. Ведь с помощью парсера можно получить информацию, совершенно не спрашивая о ней у ее владельца.

__________________

Для просмотра ссылок или изображений в подписях, у Вас должно быть не менее 30 сообщение(ий). Сейчас у Вас 0 сообщение(ий). ключевых слов- Группировка 20,000 слов за 1 минуту. Для просмотра ссылок или изображений в подписях, у Вас должно быть не менее 30 сообщение(ий). Сейчас у Вас 0 сообщение(ий). Калькулятор качества заголовков Для просмотра ссылок или изображений в подписях, у Вас должно быть не менее 30 сообщение(ий). Сейчас у Вас 0 сообщение(ий). объявлений Google Ads-Генерируй сотни объявлений |

|

|

|

|

|

#87 |

|

Пользователь

Регистрация: 01.12.2016

Сообщений: 242

Вы сказали Спасибо: 0

Поблагодарили 1 раз в 1 сообщении

Репутация: 10

|

1.2.595 - новый парсер Ahrefs, инструмент для создания CSV и много других улучшений

Улучшения

https://telegram.me/joinchat/B52bKz_xVDH2GDiEU1MPsQ |

|

|

|

|

|

#88 |

|

Пользователь

Регистрация: 01.12.2016

Сообщений: 242

Вы сказали Спасибо: 0

Поблагодарили 1 раз в 1 сообщении

Репутация: 10

|

Видео урок: Парсинг Google Maps для сбора всех организаций в определенной местности

В этом видео уроке рассмотрен способ сбора данных об организациях в указанной местности из Google Maps, используя встроенный парсер Гугл карт. Также показано как определить необходимые координаты на карте и задать их в парсере. В уроке рассмотрено:

Полезные ссылки:

|

|

|

|

|

|

#89 |

|

Пользователь

Регистрация: 16.10.2019

Сообщений: 6

Вы сказали Спасибо: 0

Поблагодарили 0 раз(а) в 0 сообщениях

Репутация: 10

|

Спасибо, много нового узнал. Только вот как проверить качество запросов которые он вытащит.

|

|

|

|

|

|

#90 |

|

Пользователь

Регистрация: 01.12.2016

Сообщений: 242

Вы сказали Спасибо: 0

Поблагодарили 1 раз в 1 сообщении

Репутация: 10

|

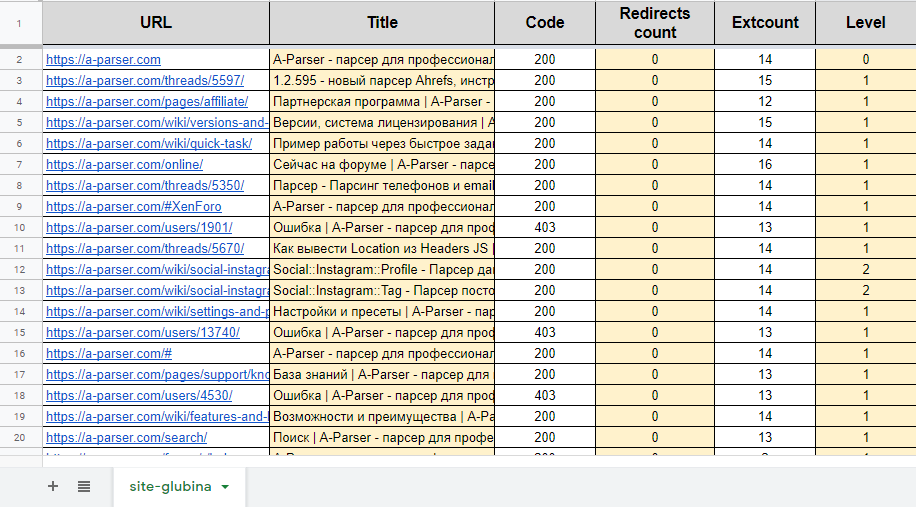

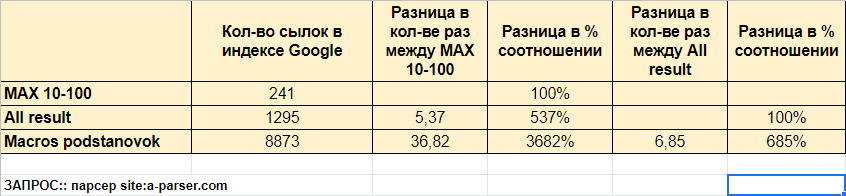

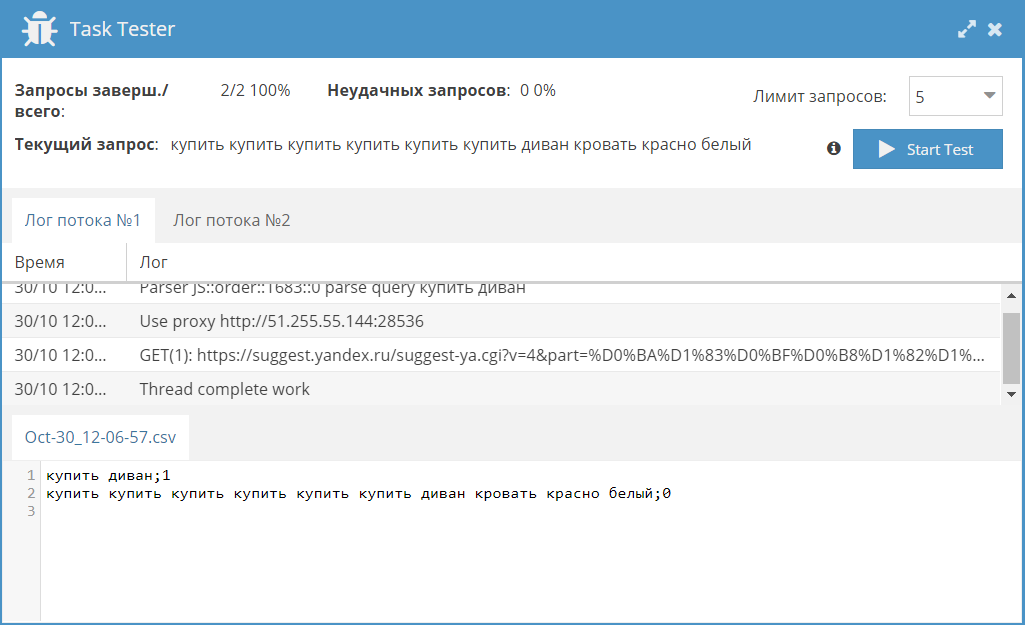

Сборник статей #9: анализ страниц сайта, парсинг всех страниц сайта из индекса и проверка запросов

9-й сборник статей. В нем мы разберемся, как делать пресеты для анализа всех страниц сайта, научимся парсить все ссылки сайта из индекса ПС и будем проверять существование запросов. Поехали! Создание пресета для анализа страниц сайта Анализ страниц на сайте - это один из самых популярных кейсов использования А-Парсера. При этом можно собирать очень много различных параметров, начиная от проверки доступности и заканчивая поиском определенных слов на странице. О том, как сделать простой анализатор сайта и пойдет речь в этой статье.  Парсинг разными способами максимум результатов из индекса поисковых систем Парсинг из индекса поисковых систем всех страниц сайта - это еще один популярный кейс для A-Parser. ПС ограничивают кол-во результатов по одному запросу, поэтому нужно как-то обходить это ограничение. Как это сделать - описано в нашей статье.  Проверка существования запросов Пресет из этого примера позволяет проверить базу ключевых слов и определить, был ли запрос одноразовым без постоянного спроса или нет. Тем самым появляется возможность отфильтровать семантику и оставить только "хорошие" запросы. Больше деталей, а также готовый пресет - по ссылке выше.  Если вы хотите, чтобы мы более подробно раскрыли какой-то функционал парсера, у вас есть идеи для новых статей или вы желаете поделиться собственным опытом использования A-Parser (за небольшие плюшки  ) - пишите здесь (https://a-parser.com/threads/3464/). ) - пишите здесь (https://a-parser.com/threads/3464/).Подписывайтесь на наш канал на Youtube - там регулярно выкладываются видео с примерами использования A-Parser, а также следите за новостями в Twitter. Предыдущие сборники статей

Присоединяйтесь к нашему Telegram каналу, нас уже 750+ - https://telegram.me/joinchat/B52bKz_xVDH2GDiEU1MPsQ |

|

|

|